I. Introducción al análisis de regresión

El análisis de regresión es una técnica estadística fundamental en la ciencia de datos y la investigación cuantitativa. Permite modelar y entender las relaciones entre variables, lo que resulta invaluable para la toma de decisiones informadas y la predicción de resultados. En este artículo, exploraremos los conceptos básicos del análisis de regresión, tanto en su forma simple como múltiple, y revisaremos las fórmulas y cálculos necesarios para llevar a cabo este tipo de análisis. Además, analizaremos la interpretación de los resultados obtenidos y discutiremos las ventajas y limitaciones del análisis de regresión. Al finalizar, proporcionaremos recomendaciones para su implementación efectiva. Si deseas mejorar tu comprensión de esta poderosa herramienta estadística, continúa leyendo para adentrarte en el análisis de regresión simple y múltiple con fórmulas.

Importancia y aplicaciones del análisis de regresión

El análisis de regresión es fundamental en el campo de la estadística y tiene múltiples aplicaciones en diferentes áreas. Es utilizado en la investigación científica para analizar y predecir fenómenos, en el ámbito empresarial para entender las relaciones entre variables y tomar decisiones basadas en datos, y en el campo de la economía para modelar y pronosticar variables económicas.

II. Conceptos básicos de regresión simple y múltiple

1. Regresión simple

La regresión simple es un tipo de análisis de regresión donde se estudia la relación entre una variable dependiente y una única variable independiente. En este caso, se utiliza una fórmula matemática para encontrar la mejor línea de regresión que se ajuste a los datos y permita predecir la variable dependiente.

III. Fórmulas y cálculos de regresión simple

3.1. Fórmula de la línea de regresión simple

La fórmula de la línea de regresión simple se representa como:

y = mx + b

Donde "y" es la variable dependiente,

"x" es la variable independiente,

"m" es la pendiente de la línea de regresión y

"b" es la intersección en el eje y.

Esta fórmula nos permite calcular el valor de y a partir de los valores de x.

Es la ecuación de una recta en forma pendiente-intersección. La variable y representa la variable dependiente o la salida de la ecuación, mientras que x representa la variable independiente o la entrada. El coeficiente m representa la pendiente de la recta, que determina la inclinación o dirección de la recta. La constante b representa la intersección y, que es el punto en el que la recta se cruza con el eje y. Esta ecuación se utiliza habitualmente en álgebra y geometría para representar gráficamente funciones lineales y resolver problemas de tasas de variación y relaciones lineales.

3.2. Línea de regresión.

La recta de regresión es una línea recta que representa el mejor ajuste de un conjunto de puntos de datos. Suele utilizarse en análisis estadísticos para ayudar a predecir valores futuros basándose en datos pasados. La pendiente y el intercepto de la recta de regresión pueden calcularse mediante diversos métodos, como la regresión por mínimos cuadrados o el análisis de correlación. La recta de regresión también puede utilizarse para determinar la fuerza y la dirección de la relación entre dos variables. En la Figura 2, la línea de regresión se muestra como una línea sólida y los puntos de datos se representan mediante círculos. La línea de regresión proporciona una representación visual de la relación entre las dos variables y puede utilizarse para hacer predicciones sobre futuros puntos de datos.

3.3. Cálculo de la pendiente (m) y la intersección (b)

La pendiente "m" de la línea de regresión se calcula mediante la fórmula:

m = (nΣ(xy) - ΣxΣy) / (nΣx^2 - (Σx)^2),

donde n es el número de observaciones,

Σxy es la suma de los productos de los valores de x e y,

Σx es la suma de los valores de x,

Σy es la suma de los valores de y, y

Σx^2 es la suma de los cuadrados de los valores de x.

Por otro lado, la intersección "b" con el eje y se calcula mediante la fórmula:

b = (Σy - mΣx) / n.

IV. Interpretación de los resultados del análisis de regresión simple

4.1. Coeficiente de determinación (R-squared)

El coeficiente de determinación, también conocido como R-cuadrado, nos indica qué porcentaje de la variabilidad de la variable dependiente puede ser explicada por la variable independiente(s). Un valor de R-cuadrado cercano a 1 indica que la variable independiente(s) explica(n) la mayoría de la variabilidad de la variable dependiente, mientras que un valor cercano a 0 indica que existe poca o ninguna relación.

4.2. Coeficiente de correlación

El coeficiente de correlación, representado por "r", nos indica la fuerza y dirección de la relación entre la variable independiente y la variable dependiente. Un valor de r cercano a 1 indica una relación positiva fuerte, mientras que un valor cercano a -1, indica una relación negativa fuerte. Si el valor de r es cercano a 0, no existe una relación lineal fuerte entre las variables.V. Fórmulas y cálculos de regresión múltiple

-1 -0.5 0 0.5 1

Relación fuerte pero inversa Sin relación Relación fuerte directa

Figura 3: Nivel de correlación entre las variables

La figura 3 muestra el nivel de correlación entre las variables. El gráfico muestra la fuerza y la dirección de la relación entre las variables. Una correlación positiva indica que a medida que aumenta una variable, también aumenta la otra. En cambio, una correlación negativa significa que, al aumentar una variable, disminuye la otra. Cuanto más se acerque el coeficiente de correlación a 1 o -1, más fuerte será la correlación. Un coeficiente de correlación de 0 indica que no existe correlación entre las variables. La información de esta figura es crucial para comprender las relaciones entre las variables y su impacto en los resultados globales. la formula par calcular el coeficiente de correlación es:

V. Regresión múltiple

La regresión múltiple es similar a la regresión simple, pero en lugar de una única variable independiente, se utilizan múltiples variables independientes para predecir la variable dependiente. En este caso, se utiliza una fórmula matemática más compleja que involucra coeficientes para cada una de las variables independientes.

5.1. Fórmula de la línea de regresión múltiple

La fórmula de la línea de regresión múltiple es la siguiente:

Y = b₀ + b₁X₁ + b₂X₂ + ... + bₙXₙ

Donde:

Y es la variable dependiente,

b₀ es el coeficiente de intersección, b₁, b₂, ..., bₙ son los coeficientes de regresión para cada variable independiente (X₁, X₂, ..., Xₙ), y X₁, X₂, ..., Xₙ son las variables independientes.

Esta fórmula nos permite predecir los valores de Y basados en los valores de las variables independientes X´.

5.2. Cálculo de los coeficientes de regresión

Para calcular los coeficientes de regresión, se utiliza el Método de Mínimos Cuadrados. Este método busca encontrar la línea de regresión que minimiza la suma de los cuadrados de las diferencias entre los valores observados y los valores predichos.

Los coeficientes de regresión se calculan mediante las siguientes fórmulas:

b₀ = Ȳ - (b₁X̅₁ + b₂X̅₂ + ... + bₙX̅ₙ)

b₁ = Σ((X₁ - X̅₁)*(Y - Ȳ)) / Σ((X₁ - X̅₁)²)

b₂ = Σ((X₂ - X̅₂)*(Y - Ȳ)) / Σ((X₂ - X̅₂)²)

...

bₙ = Σ((Xₙ - X̅ₙ)*(Y - Ȳ)) / Σ((Xₙ - X̅ₙ)²)

Donde:

Ȳ es la media de los valores observados de Y,

X̅₁, X̅₂, ..., X̅ₙ son las medias de las variables independientes X₁, X₂, ..., Xₙ,

Σ representa la suma de los valores, y

/ representa la división.

Estas fórmulas nos permiten calcular los coeficientes de regresión necesarios para construir la línea de regresión múltiple.

VI. Interpretación de los resultados del análisis de regresión múltiple

6.1. Análisis de la significancia de los coeficientes

Es importante analizar la significancia estadística de los coeficientes de regresión para determinar si las variables independientes tienen un efecto significativo sobre la variable dependiente.

Para esto, se calcula el valor p asociado a cada coeficiente. Si el valor p es menor que un umbral predefinido (generalmente 0.05), se considera que el coeficiente es estadísticamente significativo.

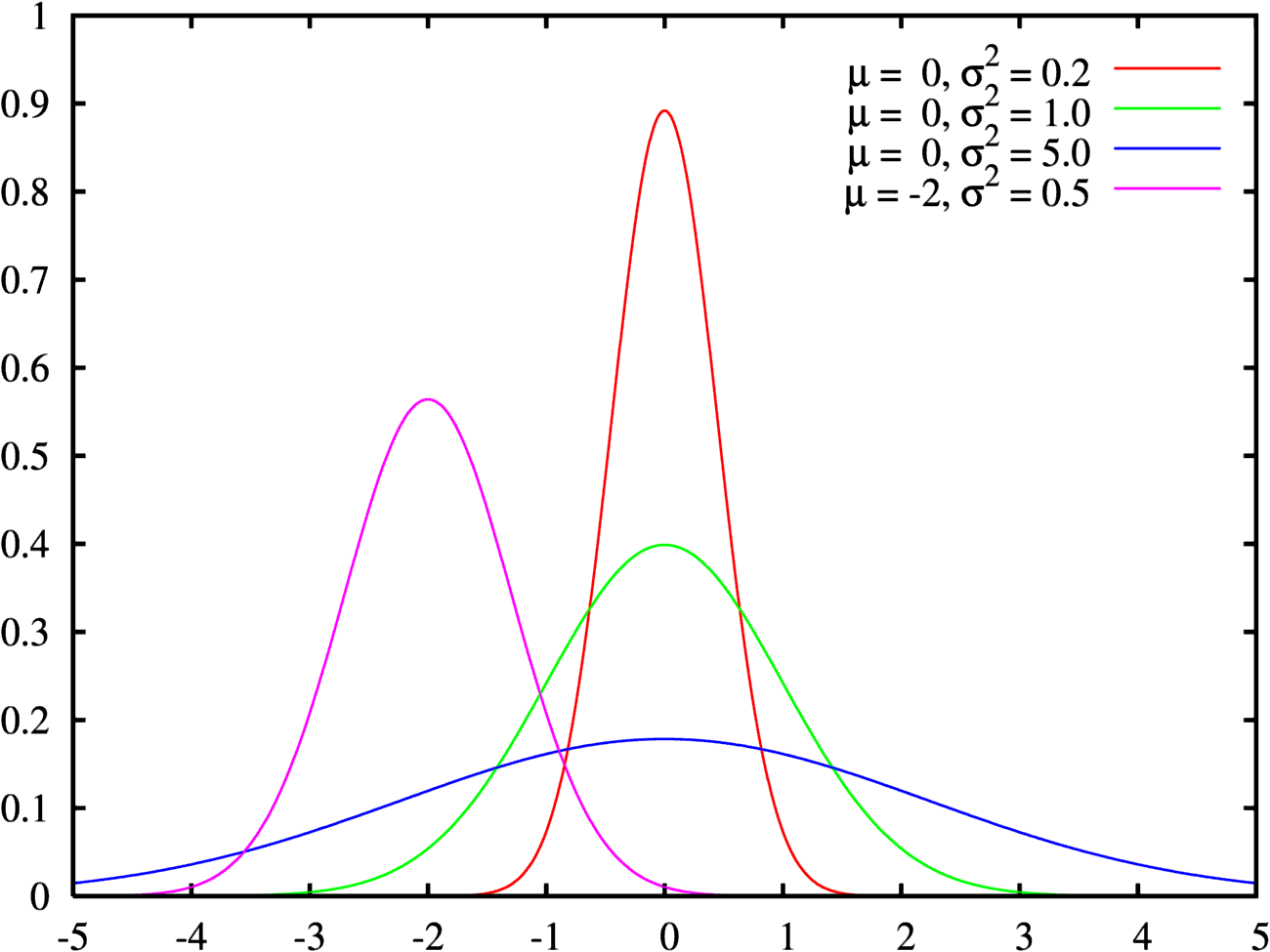

Figura 1: Distribución Normal Estándar, Región crítica

Además, se puede utilizar el coeficiente de determinación (R²) para evaluar la calidad del ajuste del modelo. Este valor indica la proporción de la varianza total de la variable dependiente que puede ser explicada por las variables independientes. El coeficiente de determinación, también conocido como R-cuadrado, es una medida estadística que determina la proporción de la varianza de la variable dependiente que puede ser explicada por la(s) variable(s) independiente(s). En otras palabras, mide lo bien que se ajusta la recta de regresión a los puntos de datos.

El valor R-cuadrado oscila entre 0 y 1, donde 0 indica que el modelo no explica nada de la variabilidad de los datos y 1 indica que el modelo explica toda la variabilidad de los datos. He aquí algunas pautas generales para interpretar los valores R-cuadrado:

- Los valores de R-cuadrado entre 0,7 y 1 indican una fuerte relación entre las variables independiente y dependiente. Esto significa que el modelo explica una gran proporción de la variabilidad de los datos.

- Los valores de R-cuadrado entre 0,4 y 0,7 indican una relación moderada entre las variables independientes y dependientes. Esto significa que el modelo explica una proporción moderada de la variabilidad de los datos.

- Los valores de R-cuadrado inferiores a 0,4 indican una relación débil entre las variables independiente y dependiente. Esto significa que el modelo explica una pequeña proporción de la variabilidad de los datos.

Es importante señalar que los valores de R-cuadrado no deben utilizarse como único criterio para evaluar la bondad del ajuste de un modelo de regresión. También deben tenerse en cuenta otros factores, como la significación de los coeficientes, la distribución de los residuos y la presencia de valores atípicos.

En conclusión, comprender los distintos niveles del coeficiente de determinación puede ayudarte a evaluar la fuerza de la relación entre tus variables y la precisión de tu modelo de regresión. Ten en cuenta que los valores de R-cuadrado no son el único factor a considerar al evaluar el rendimiento de tu modelo.

6.2. Análisis de la multicolinealidad

La multicolinealidad es la presencia de alta correlación entre las variables independientes en un modelo de regresión múltiple. Esto puede causar problemas en la interpretación de los coeficientes de regresión y afectar la precisión de las predicciones.

Para detectar la multicolinealidad, se puede calcular el factor de inflación de la varianza (VIF) para cada variable independiente. Un VIF mayor a 1 indica la presencia de multicolinealidad. En caso de detectar multicolinealidad, se pueden tomar medidas como eliminar una de las variables correlacionadas o combinarlas en una sola variable.

Como se calcula el factor de inflación de la varianza?

Calcular el factor de inflación de la varianza es un paso importante en el análisis y la interpretación de los datos. El factor de inflación se utiliza para ajustar la varianza de una muestra para tener en cuenta el hecho de que puede no representar con exactitud a la población en su conjunto. Esto es especialmente importante cuando se sacan conclusiones o se hacen predicciones basadas en los datos.

Para calcular el factor de inflación, primero tienes que calcular la relación entre la varianza de la población y la varianza de la muestra. Esta proporción se conoce como razón F. El cociente F se calcula dividiendo la varianza de la población por la varianza de la muestra.

Una vez calculado el cociente F, puedes utilizarlo para calcular el factor de inflación. El factor de inflación se calcula sacando la raíz cuadrada del cociente F. Esto te dará un número que puedes utilizar para ajustar la varianza de la muestra a fin de tener en cuenta el factor de inflación.

Es importante señalar que el factor de inflación sólo se utiliza cuando el tamaño de la muestra es pequeño en relación con el tamaño de la población. Si el tamaño de la muestra es grande, el factor de inflación será cercano a uno, y no habrá mucha necesidad de ajustar la varianza de la muestra.

En resumen, calcular el factor de inflación de la varianza es un paso importante en el análisis y la interpretación de los datos. Nos permite ajustar la varianza de la muestra para tener en cuenta el hecho de que puede no representar con exactitud a la población en su conjunto. Si sabemos cómo calcular el factor de inflación, podremos hacer conclusiones y predicciones más precisas basadas en nuestros datos.

VII. Ventajas y limitaciones del análisis de regresión

7.1. Ventajas del análisis de regresión

El análisis de regresión ofrece varias ventajas. Primero, permite examinar las relaciones entre variables y comprender cómo una variable podría influir en otra. Esto es útil para hacer predicciones y tomar decisiones informadas.

Además, el análisis de regresión puede ayudar a identificar variables importantes y descartar variables irrelevantes. Esto permite simplificar modelos complejos y mejorar la interpretación.

Otra ventaja es que el análisis de regresión puede proporcionar medidas de significancia estadística y calidad de ajuste, lo que ayuda a evaluar la confiabilidad y eficacia del modelo.

7.2. Limitaciones del análisis de regresión

El análisis de regresión también tiene sus limitaciones. No puede establecer relaciones de causalidad, sino solo identificar asociaciones entre variables. Además, se basa en ciertas suposiciones, como la linealidad y la independencia de los errores.

Además, el análisis de regresión puede verse afectado por la presencia de datos atípicos, la falta de representatividad de la muestra y la multicolinealidad. Estos problemas pueden comprometer la precisión y confiabilidad de los resultados.

Es importante tener en cuenta estas limitaciones al interpretar los resultados del análisis de regresión y considerar otras técnicas o enfoques complementarios cuando sea necesario.

VIII. Conclusiones y recomendaciones para el análisis de regresión

En conclusión, el análisis de regresión múltiple proporciona una herramienta poderosa para examinar las relaciones entre variables y hacer predicciones. Con las fórmulas y cálculos adecuados, podemos construir una línea de regresión múltiple y calcular los coeficientes de regresión necesarios.

Es importante interpretar los resultados del análisis teniendo en cuenta la significancia estadística de los coeficientes y la posible presencia de multicolinealidad. Se deben considerar también las ventajas y limitaciones del análisis de regresión, así como las recomendaciones para hacer un uso adecuado de esta técnica.

En resumen, el análisis de regresión múltiple nos brinda información valiosa para comprender y predecir las relaciones entre variables, pero debemos tener en cuenta sus limitaciones y considerar otros enfoques cuando sea necesario.

Preguntas frecuentes a tener en cuenta cuando se aplica análisis de regresión

1. ¿Cuál es la diferencia entre regresión simple y regresión múltiple?

La regresión simple implica analizar la relación entre dos variables, donde una es considerada la variable independiente y la otra la variable dependiente. Por otro lado, la regresión múltiple involucra la relación entre una variable dependiente y dos o más variables independientes. La regresión múltiple permite tener en cuenta múltiples factores que podrían afectar la variable dependiente, lo que puede proporcionar un modelo más preciso y completo.

2. ¿Cómo interpretar el coeficiente de determinación (R-squared)?

El coeficiente de determinación, también conocido como R-cuadrado, indica la proporción de la variabilidad de la variable dependiente que puede ser explicada por el modelo de regresión. Un valor de R-cuadrado cercano a 1 significa que el modelo puede explicar la mayoría de la variabilidad de la variable dependiente. Sin embargo, es importante tener en cuenta que el R-cuadrado por sí solo no valida la calidad del modelo y otros factores deben ser considerados, como la significancia de los coeficientes y la validez de las suposiciones del modelo.

3. ¿Cuáles son las ventajas del análisis de regresión?

El análisis de regresión proporciona una serie de ventajas, como la capacidad de modelar y predecir relaciones entre variables, identificar factores significativos que afectan la variable dependiente, y evaluar el impacto de diferentes variables independientes en la variable dependiente. Además, el análisis de regresión puede ayudar a identificar patrones y tendencias, lo que permite tomar decisiones informadas y optimizar los resultados.

4. ¿Cuáles son las limitaciones del análisis de regresión?

A pesar de sus ventajas, el análisis de regresión también tiene limitaciones. Algunas de ellas incluyen la necesidad de cumplir con ciertas suposiciones y condiciones para obtener resultados precisos y válidos, la sensibilidad a los valores atípicos que pueden afectar los resultados, y la posibilidad de correlación espuria o relaciones falsas entre variables. Además, el análisis de regresión asume una relación lineal entre las variables, lo que puede no ser adecuado en todas las situaciones. Por lo tanto, es esencial evaluar cuidadosamente estas limitaciones al interpretar los resultados del análisis de regresión.

Análisis de Regresión simple y múltiple con fórmulas

IX Ejemplos en Excel

Excel es una potente herramienta que puede utilizarse para analizar y organizar datos. Existen innumerables funciones y fórmulas que pueden utilizarse para manipular datos en Excel. En este artículo, exploraremos algunos ejemplos de cómo puede utilizarse Excel en diversos escenarios.

Análisis de datos: Excel puede utilizarse para analizar datos de diversas formas.

próximamente el video!

![\includegraphics[angle=-90, width=0.8\textwidth]{fig06-16.epsi}](http://www.bioestadistica.uma.es/libro/img1151.gif)

![\includegraphics[angle=-90, width=0.8\textwidth]{fig06-17.epsi}](http://www.bioestadistica.uma.es/libro/img1152.gif)

![\includegraphics[angle=-90, width=0.8\textwidth]{fig06-18.epsi}](http://www.bioestadistica.uma.es/libro/img1154.gif)

![\begin{displaymath}{{\cal P}}[T\leq t] = F_T(t) = \int_{-\infty}^t f_T(x)\,dx

= ...

...qrt{n\pi}}

\left(1+\frac{x^2}{n}\right)^{-\frac{n+1}{2}}\, dx}

\end{displaymath}](http://www.bioestadistica.uma.es/libro/img1155.gif)